Más de un millón de apelaciones recibió el Consejo Asesor de Contenido, independiente del grupo Meta, por parte de usuarios que buscaban una revisión sobre la decisión que esas redes tomaron en la eliminación o restricción de sus contenidos. En un informe, se publicó cómo se resolvieron los primeros 20 casos.

Una persona en Brasil publica en Instagram en 2020 una imagen donde se ven los pechos de una mujer como parte de una campaña para concientizar sobre el cáncer de mama, pero la red social la elimina por «desnudo». Dos años después, Donald Trump postea un video durante la toma del Capitolio en Washington con la frase «los queremos», en supuesta referencia a los vándalos, y Facebook le suspende de forma indefinida la cuenta de sus plataformas por el riesgo de que su presencia fomente una «escalada de violencia».

Estas decisiones, junto a más de “un millón de apelaciones», fueron revisadas por el Consejo Asesor de Contenidos, un organismo creado por Meta (la corporación de la que dependen Facebook, Instagram y Whatsapp, entre otras empresas) que cuenta con independencia de Mark Zuckerberg.

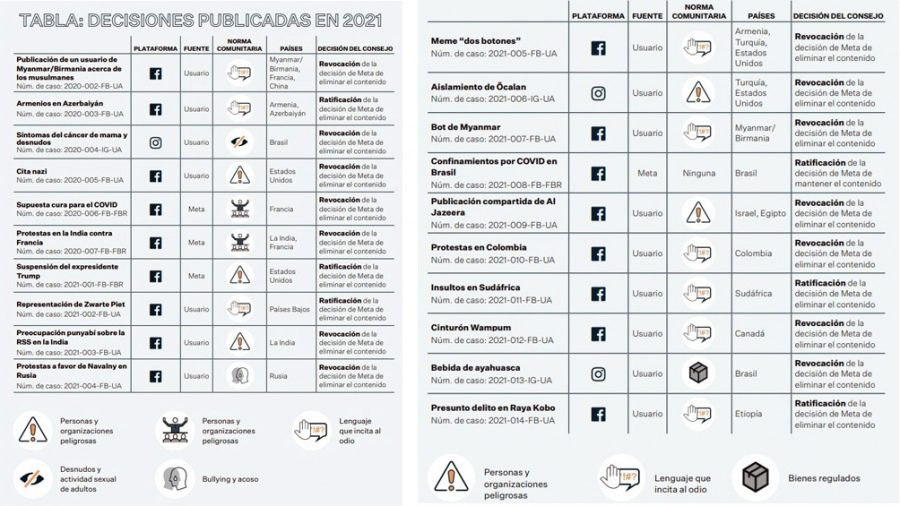

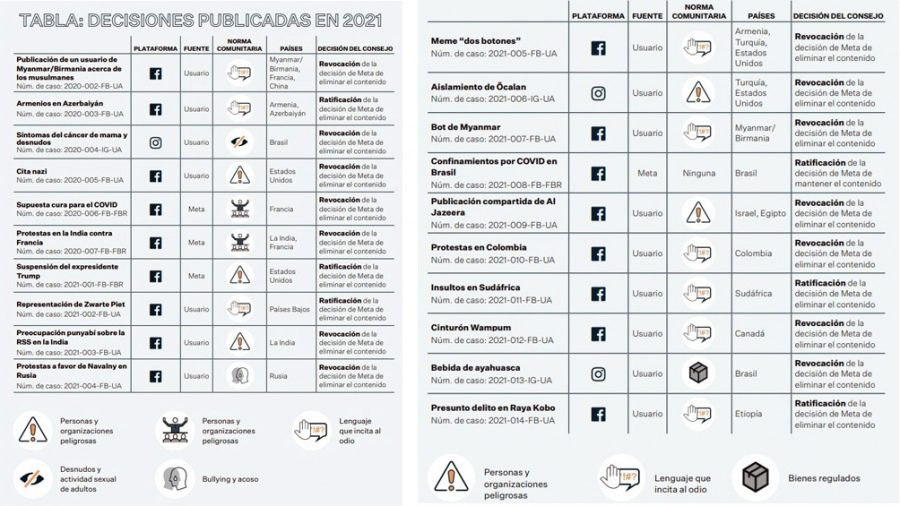

Hace unos días, el Consejo reveló su primer informe sobre cómo se resolvieron 20 casos de contenidos eliminados o restringidos en Facebook e Instagram.

Un organismo que se fundó en 2018 bajo una idea: “Las empresas de redes sociales no tienen que tomar por sí mismas decisiones relacionadas con la moderación de contenidos”.

También fue parte de una propuesta que la propia Meta presentó en noviembre de 2018, bajo la cual «permitía a las personas recurrir las decisiones relacionadas con contenidos a un órgano independiente y cuyas decisiones fuesen vinculantes».

En su plan de acción, este Consejo no solo revierte las decisiones de Meta cuando así lo estima necesario, sino que también recomienda cambios de políticas que «mejoran el tratamiento que reciben los usuarios y que proporcionan mayor transparencia».

La protección de la libertad de expresión y de otros derechos humanos, la consideración del contexto y el tratamiento imparcial a los usuarios con independencia del lugar en el que se encuentren, son algunos de los principios en los que se basa para tomar decisiones.

El primer informe del Consejo

Entre octubre de 2020 y diciembre de 2021, el Consejo recibió más de un millón de solicitudes de usuarios sobre la «revisión independiente» de decisiones de Meta sobre moderación de contenidos. Un promedio de 2.649 casos diarios.

Además, el mismo Meta le remitió 47 casos. En promedio, 8 de cada 10 usuarios apeló a la restauración de contenidos en relación con las reglas de esas redes sobre bullying, lenguaje que incita al odio o violencia e incitación.

El Consejo tuvo en cuenta más de 10.000 comentarios de personas y organizaciones de todo el mundo para la toma de decisiones, y emitió a Meta 86 recomendaciones, de las cuales ese grupo acreditó la realización de progresos o la implementación de las recomendaciones.

En el informe se detallaron las primeras 20 decisiones completas, sobre las que Meta se retractó en 14 ocasiones y se ratificó en 6 ocasiones.

Además de enfocarse en los contenidos de esas redes, el Consejo ya planifica su rol en la moderación de contenidos en el incipiente metaverso que Meta está desarrollando, y por el que ya invirtió 10 mil millones de dólares.

Con este trabajo, también busca brindar un «marco de referencia fidedigno para otras empresas de redes sociales, editores de plataformas, reguladores y responsables políticos del mundo que se enfrentan a las tensiones y los retos intrínsecos de la moderación de contenidos».

Meta tomó decisiones, pero el Consejo las revocó

Una de las decisiones tomadas por el Consejo «sentó un importante precedente al poner de relieve la incapacidad de los sistemas de cumplimiento de normas automatizados de Meta», según describió, para distinguir imágenes permitidas de pezones femeninos al descubierto en una campaña de concienciación contra el cáncer de mama.

En concreto, un usuario de Brasil publicó en octubre de 2020 una imagen en Instagram con un título en portugués cuyo objetivo era generar conciencia acerca del cáncer de mama. Pero un sistema automatizado encargado del cumplimiento de la norma de Facebook en cuanto a desnudos y actividad sexual de adultos eliminó la publicación (la norma también era aplicable a Instagram).

En este caso, el Consejo revocó la decisión de Meta porque la norma contempla, como excepción, la exhibición de desnudos en los casos en los que el usuario pretende “concienciar acerca de una causa o con fines educativos o médicos“ y permite, de manera específica, la publicación de imágenes de pezones femeninos al descubierto para “incrementar la concienciación acerca del cáncer de mama”.

Además, recomendó ofrecer a los usuarios la posibilidad de apelar las decisiones que tomen los sistemas automatizados para que se realice una revisión humana cuando se les informe que su contenido infringió la norma comunitaria de Facebook sobre desnudos y actividad sexual de adultos.

Suspensión de la cuenta de Trump

El caso de Trump fue más largo y tuvo varios idas y vueltas entre el Consejo y Meta. Comenzó el 6 de enero de 2021, luego de que una multitud entrara a la fuerza en el edificio del Capitolio en Washington, y el por entonces presidente de Estados Unidos publicara un video en Facebook e Instagram, en el que decía lo siguiente:

“Sé que les duele, que se sienten heridos. Nos han robado las elecciones. Ha sido un triunfo aplastante y todos lo saben, sobre todo los del otro bando, pero deben irse a casa. Debemos tener paz, ley y orden. Debemos respetar a la maravillosa gente que respeta la ley y el orden. No queremos que nadie salga herido. Son tiempos muy difíciles».

«Nunca antes había ocurrido nada así, que nos robaran a todos: a mí, a ustedes, al país. Estas elecciones han sido un fraude, pero no podemos actuar de manera que favorezca a esas personas. Debemos tener paz. Así que vuelvan a casa. Los queremos. Son muy especiales. Han visto lo que ocurre. Han visto la forma tan vil y malvada con la que tratan a los demás. Sé cómo se sienten. Pero vuelvan a casa y en paz”.

Una hora más tarde, Meta eliminó el video por «infringir la norma de personas y organizaciones peligrosas». Luego, Trump publicó una declaración en Facebook:

“Estas son las cosas que pasan cuando una victoria aplastante y respetable en las elecciones se arrebata de forma tan feroz y abrupta a los grandes patriotas que han recibido un trato terriblemente injusto durante tanto tiempo. Vuelvan a casa con amor y en paz. ¡Recuerden siempre este día!”

Ocho minutos más tarde, Meta eliminó esta publicación «por infringir la norma comunitaria de personas y organizaciones peligrosas». Asimismo, bloqueó la cuenta de Trump para evitar que publicara más contenidos en Facebook e Instagram.

Dos semanas más tarde, Meta remitió al Consejo la decisión de suspender el acceso de Trump a sus cuentas de manera indefinida. La compañía también solicitó al Consejo observaciones o recomendaciones sobre suspensiones de cuentas de usuarios que son líderes políticos.

En su blog oficial, Meta había explicado que eliminó las publicaciones de contenido por infringir la política que prohíbe “la exaltación, el apoyo o la representación de eventos designados como violentos”. Según ese grupo, el contenido también infringía la parte de la política que prohíbe “la exaltación de individuos que participan en actos de violencia organizada”.

Meta y una revisión polémica

La empresa explicó que la decisión de suspender la posibilidad de publicación de Trump con carácter indefinido se tomó en base a las normas internacionales sobre derechos humanos, sobre todo en base al artículo 19 del Pacto Internacional de Derechos Civiles y Políticos y la Observación general 34 del Comité de Derechos Humanos de la ONU, que permite aplicar restricciones necesarias y proporcionadas al derecho de libertad de expresión en situaciones de emergencia pública que supongan una amenaza para la vida de la nación.

Lo que hizo el Consejo sobre este caso fue ratificar la decisión inicial de suspender la cuenta pero revocar la decisión de mantener la suspensión con carácter indefinido.

El organismo estimó que, dada la gravedad de las infracciones y el continuo riesgo de escalada de la violencia, era justificada la medida de suspender las cuentas de Trump el 6 de enero de 2021 y de ampliar la suspensión el 7 de enero. Así como también determinó que las dos publicaciones en cuestión infringían las normas comunitarias de Facebook e Instagram.

Pero tras un ida y vuelta con la compañía, el Consejo consideró «inapropiada la decisión de Meta de imponer una sanción indeterminada y sin fundamentos normativos de suspensión indefinida”.

En respuesta a esta decisión, Meta anunció la adopción de un nuevo conjunto de protocolos de cumplimiento de normas “para casos excepcionales como este” y ,según esos protocolos, actualizó la suspensión de la cuenta de Trump por dos años a contar desde el 7 de enero de 2021.

Al aproximarse a la fecha de vencimiento de la sanción, la compañía se comprometió a «buscar expertos para evaluar si ya no existen riesgos para la seguridad pública», entre otros escenarios.

El Consejo asesor de contenido ofrece un medio para apelar las decisiones de contenido en Facebook o Instagram. Para iniciar la apelación, tocar aquí.